Proxmox redimensionnement d'un disk

Proxmox redimensionnement d'un disk

Proxmox redimensionnement d'un disk

Proxmox VE :

Mise en place de machines sur un serveur ou des serveurs avec des logiciels open sources !

Openvz et KVM.

Avec la nouvelle version de proxmoxve3.1 un message a chaque connexion apparaît pour vous dire que vous n'avez pas d'abonnement.

Pour supprimer le message procéder comme suit : Il faut modifier le fichier pvemanagerlib.js

ouvrir un terminal en

ma_machine_jls# ssh root@votreserveur.votredommaine

Faire une sauvegarde du fichier

proxmox# cp /usr/share/pve-manager/ext4/pvemanagerlib.js /usr/share/pve-manager/ext4/pvemanagerlib.js_BKP

dans le fichier pvemanagerlib.js (modification autorisée licence GPL v3)

proxmox# vim /usr/share/pve-manager/ext4/pvemanagerlib.js

proxmoxmodif.png

a la ligne 20694 colonne 7-21 (voir ci dessus la ligne déjà modifiée

Changer :

if (data.status !== 'Active') {

par :

if (false) {

ensuite sauvegarder votre fichier esc :wq

Redémarrer le service :

proxmox# /etc/init.d/pve-manager restart

proxmox# qemu-img resize /var/lib/vz/images/106/vm-106-disk-1.raw +20G

proxmox# qemu-img resize /var/lib/vz/images/106/vm-106-disk-1.qcow2 +30G

Convertir une machine .vmdk en qcow2

proxmox# qemu-img convert -O qcow2 VM_vmware.vmdk VM_kvm.qcow2

Attention le -O est un O majuscule et non pas un zéro

Connaitre la version de votre proxmox

proxmox# pveversion -v

Aplatir le fichier disque virtuel (vmdk)

Si votre disque virtuel VMware est découpé en fichiers de 2Go, il faut l’aplatir, c’est a dire recombiner tous les fichiers de 2G pour former un seul fichier.

proxmox# ls

proxmox# vm.win2003.vmdk

proxmox# vm.win2003-0.vmdk

proxmox# vm.win2003-01.vmdk

proxmox# vm.win2003-2.vmdk …

Pour ce faire, il suffit d’utiliser l’utilitaire “vmware-vdiskmanager” (sur le serveur WMware ou sur la machine ou a été installé vmware vcenter converter standalone) : Cela ne fonctionne

pas si vous ne possédez pas de console vcenter. Moi je ne dispose pas de vcenter et il faut impérativement installer vmware-tools sur la machine virtuelle. Ou alors créer une machine virtuelle

avec les outils vmware (vmware-desktop) et ensuite installer les outils vmware.

Supprimer une machine de votre cluster pour la remettre

Stopping cluster:

Stopping dlm_controld... [ OK ]

Stopping fenced... [ OK ]

Stopping cman... [ OK ]

Waiting for corosync to shutdown:[ OK ]

Unloading kernel modules... [ OK ]

Unmounting configfs... [ OK ]

Stopping pve cluster filesystem: pve-cluster.

# mv -rf /etc/pve/nodes/* /tmp/pvenodes-sauv/

rm: cannot remove `/etc/pve/nodes/*': Transport endpoint is not connected

# service pve-cluster start

Starting pve cluster filesystem : pve-cluster.

# service cman start

# /etc/init.d/apache2 start

Redimensionnement un Disque

Forcer le unmout d'un périphérique DEBIAN-Ubuntu qui possède lvm

Je suis récemment tombé sur un problème de umout /var/lib/vz qui a refusé de se démonter.

La commande

#umout /var/lib/vz ne fonctionnant pas

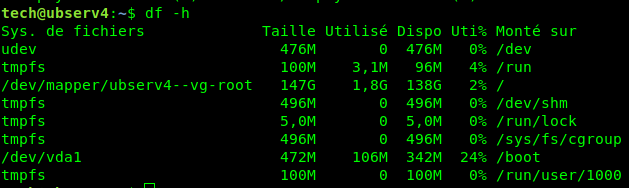

Voici mes disk et le système de fichiers /dev/mapper/pve-root est full

root@proxmox1a:~# df -h

Sys. fich. Taille Util. Dispo Uti% Monté sur

udev 10M 0 10M 0% /dev

tmpfs 2,4G 452K 2,4G 1% /run

/dev/mapper/pve-root 95G 94G 0 100% /

tmpfs 5,0M 0 5,0M 0% /run/lock

tmpfs 4,8G 38M 4,7G 1% /run/shm

/dev/mapper/pve-data 1,3T 170G 1,1T 14% /var/lib/vz

/dev/sda1 495M 131M 339M 28% /boot

tmpfs 8,6G 32K 8,6G 1% /tmp

/dev/fuse 30M 52K 30M 1% /etc/pve

freenas2.scola.ac-paris.fr:/mnt/DiskFree22/BackupVM_Proxmox/P1-3 1,8T 185G 1,6T 11% /mnt/pve/Back2freenas

/var/lib/vz/private/114 80G 741M 80G 1% /var/lib/vz/root/114

none 1,5G 4,0K 1,5G 1% /var/lib/vz/root/114/dev

none 1,5G 0 1,5G 0% /var/lib/vz/root/114/dev/shm

/var/lib/vz/private/113 80G 1,2G 79G 2% /var/lib/vz/root/113

none 1,5G 4,0K 1,5G 1% /var/lib/vz/root/113/dev

none 1,5G 0 1,5G 0% /var/lib/vz/root/113/dev/shm

root@proxmox1a:~# umount /var/lib/vz

umount: /var/lib/vz: device is busy.

(In some cases useful info about processes that use

the device is found by lsof(8) or fuser(1))

Après la lecture sur la syntaxe de fuser, voici la commande qui a très bien fonctionné pour moi :

root@proxmox1a:~# fuser -km /var/lib/vz

Cette commande cherche tous les processus qui accède à /var/lib/vz qui est mon point de montage tout les process doivent être arrêtés. Car je suis pas sûr de la propriété des processus qui seraient à tués.

/var/lib/vz: 6645 6709 6748

moyen de réponse qu'un processus avec l'ID 6645 6709 6748 a pris fin.

Et pour m’assure qu'il n'y a plus de process je relance la commande

root@proxmox1a:~# fuser -km /var/lib/vz

Pas de réponse donc je suppose que tout est ok

#Maintenant je relance ma commande umount /var/lib/vz

root@proxmox1a:~# umount /var/lib/vz

Pas de réponse donc ok

# Réaliser un check du système de fichier

root@proxmox1a:~# e2fsck -f /dev/mapper/pve-data

e2fsck 1.42.5 (29-Jul-2012)

Passe 1 : vérification des i-noeuds, des blocs et des tailles

Passe 2 : vérification de la structure des répertoires

Passe 3 : vérification de la connectivité des répertoires

Passe 4 : vérification des compteurs de référence

Passe 5 : vérification de l'information du sommaire de groupe

/dev/mapper/pve-data : 95650/82763776 fichiers (1.2% non contigüs), 49567234/331055104 blocs

root@proxmox1a:~# resize2fs /dev/mapper/pve-data 1T

resize2fs 1.42.5 (29-Jul-2012)

En train de redimensionner le système de fichiers sur

/dev/mapper/pve-data à 268435456 (4k) blocs.

Le système de fichiers /dev/mapper/pve-data a maintenant une taille de 268435456 blocs.

Voilà pour la partie resize passons maintenant à la réduction

root@proxmox1a:~# lvreduce -L-140G /dev/mapper/pve-data

WARNING: Reducing active logical volume to 1,10 TiB

THIS MAY DESTROY YOUR DATA (filesystem etc.)

Do you really want to reduce data? [y/n]: y

Reducing logical volume data to 1,10 TiB

Logical volume data successfully resized

Nous pouvons maintenant remoter notre système de fichier afin de faire un extend

root@proxmox1a:~# mount /var/lib/vz

root@proxmox1a:~# lvextend --extents +100%FREE /dev/mapper/pve-root

Extending logical volume root to 140,00 GiB

Logical volume root successfully resized

Ensuite faire un resize2fs pour attribuer le 140G au système de fichier

root@proxmox1a:~# resize2fs /dev/mapper/pve-root

resize2fs 1.42.5 (29-Jul-2012)

Le système de fichiers de /dev/mapper/pve-root est monté sur / ; le changement de taille doit être effectué en ligne

old_desc_blocks = 6, new_desc_blocks = 16

En train d'effectuer un changement de taille en ligne de /dev/mapper/pve-root vers 66059264 (4k) blocs.

Le système de fichiers /dev/mapper/pve-root a maintenant une taille de 66059264 blocs.

Vérifier le système de fichiers avec la commandes

root@proxmox1a:~# df -ha

Sys. fich. Taille Util. Dispo Uti% Monté sur

sysfs 0 0 0 - /sys

proc 0 0 0 - /proc

udev 10M 0 10M 0% /dev

devpts 0 0 0 - /dev/pts

tmpfs 2,4G 448K 2,4G 1% /run

/dev/mapper/pve-root 249G 94G 143G 40% /

tmpfs 5,0M 0 5,0M 0% /run/lock

tmpfs 4,8G 47M 4,7G 1% /run/shm

/dev/sda1 495M 131M 339M 28% /boot

tmpfs 8,6G 32K 8,6G 1% /tmp

rpc_pipefs 0 0 0 - /var/lib/nfs/rpc_pipefs

/dev/fuse 30M 52K 30M 1% /etc/pve

none 0 0 0 - /sys/kernel/config

beancounter 0 0 0 - /proc/vz/beancounter

container 0 0 0 - /proc/vz/container

fairsched 0 0 0 - /proc/vz/fairsched

freenas2.scola.ac-paris.fr:/mnt/DiskFree22/BackupVM_Proxmox/P1-3 1,8T 185G 1,6T 11% /mnt/pve/Back2freenas

/dev/mapper/pve-data 1008G 170G 839G 17% /var/lib/vz

Cool sa marche

jean-luc Simonet

Cet article ne reçoit pas de commentaire.